تکامل موتورهای جستجو (۱۹۹۵–۲۰۲۵): چرا سئو متولد شد و چگونه به یک استراتژی حیاتی تبدیل شد؟

سلام! من مرتضی عظیمی هستم. سالهاست که در دنیای پیچیده و پویای سئو، استراتژی محتوا و بهینهسازی برای انواع موتورهای جستجو (GEO, AEO, AIO) فعالیت میکنم. در این مسیر، بارها با این سوال مواجه شدهام: «سئو واقعاً از کجا آمد و چرا اینقدر مهم است؟» بسیاری سئو را مجموعهای از تکنیکها برای «شکست دادن گوگل» میدانند، اما این دیدگاه کاملاً اشتباه است. سئو یک تقابل نیست؛ یک همسویی استراتژیک با عمیقترین هدف موتورهای جستجو است: ارائه بهترین، سریعترین و معتبرترین پاسخ به سوالات انسان.

پاسخ به این سوال، یک سفر جذاب در تاریخ اینترنت است. این راهنما برای کسانی نوشته شده که میخواهند از سطح یک «اجراکننده تکنیکهای سئو» فراتر رفته و به یک «استراتژیست» تبدیل شوند؛ کسی که فلسفه پشت الگوریتمها را درک میکند و میتواند خود را برای آینده آماده کند. درک تاریخ به ما «چرا»ی هر تکنیک را میآموزد. چرا امروزه بر تجربه کاربری تاکید میکنیم؟ چرا اعتبار نویسنده مهم است؟ پاسخ تمام این سوالات در دل همین تکامل نهفته است. اگر دانشجو، مدیر بازاریابی یا صاحب کسبوکاری هستید که میخواهید بدانید چرا سرمایهگذاری روی سئو، سرمایهگذاری روی آینده کسبوکار شماست، این مقاله برای شماست.

آنچه در این راهنمای جامع خواهید آموخت:

- فلسفه وجودی سئو: چرا بهینهسازی برای موتورهای جستجو یک ضرورت است و نه یک انتخاب.

- نقاط عطف تاریخی: از اولین موتورهای جستجو تا الگوریتمهای هوشمند امروزی گوگل.

- تحلیل الگوریتمهای کلیدی: چگونه پاندا، پنگوئن، مرغ مگسخوار و RankBrain بازی را برای همیشه تغییر دادند.

- اصول سئوی مدرن: چرا امروز همه چیز حول محور تجربه کاربری، تخصص، اعتبار و اعتماد (E-E-A-T) میچرخد.

- نگاهی به آینده: چگونه با ظهور هوش مصنوعی مولد (SGE) استراتژی سئوی خود را تطبیق دهیم.

مقدمه: دنیای وب قبل از نظم؛ چرا به موتورهای جستجو نیاز پیدا کردیم؟

در اوایل دهه ۱۹۹۰، اینترنت مانند یک کتابخانه عظیم و بدون فهرست بود. هزاران صفحه وب در حال شکلگیری بودند، اما هیچ راهی برای یافتن اطلاعات مشخص وجود نداشت. شما باید آدرس دقیق یک وبسایت (URL) را میدانستید تا به آن دسترسی پیدا کنید. این فضا بیشتر شبیه به یک آرشیو آکادمیک بود تا یک شبکه اطلاعاتی جهانی و در دسترس برای عموم.

دوران فهرستهای دستی (Manual Directories) و اولین خزندهها

اولین تلاشها برای سازماندهی این هرجومرج، «دایرکتوریهای وب» مانند Yahoo! Directory بودند. در این سیستم، ویراستاران انسانی وبسایتها را به صورت دستی بررسی کرده، توضیح کوتاهی برایشان مینوشتند و در دستهبندیهای مشخصی (مانند ورزش، اخبار، سرگرمی) قرار میدادند. این روش کیفیت بالایی داشت اما دو ضعف بزرگ داشت: بسیار کند بود و با رشد انفجاری وب، کاملاً مقیاسناپذیر شد.

همزمان، اولین موتورهای جستجوی واقعی با استفاده از «خزندههای وب» (Web Crawlers) یا «رباتها» پدیدار شدند. موتورهایی مانند Archie (که فایلهای FTP را فهرست میکرد)، WebCrawler، Lycos و AltaVista پیشگامان این عرصه بودند. آنها به طور خودکار در وب میخزیدند و صفحات را ایندکس (فهرست) میکردند. AltaVista به دلیل قابلیت جستجوی متن کامل در میان میلیونها صفحه، به سرعت محبوب شد.

چالش اصلی: چگونه از میان میلیونها صفحه، بهترین را پیدا کنیم؟

اینجا بود که مشکل اصلی نمایان شد. این موتورها در «یافتن» صفحات خوب بودند، اما در «رتبهبندی» آنها ضعیف عمل میکردند. الگوریتمهایشان ساده بود و نتایج را اغلب بر اساس «تراکم کلمات کلیدی» (Keyword Density) رتبهبندی میکردند. این موضوع راه را برای سوءاستفادههای گسترده باز کرد. وبمسترها به سادگی با تکرار صدها باره یک کلمه (تکنیکی که بعداً Keyword Stuffing نام گرفت)، میتوانستند موتورهای جستجو را فریب داده و رتبههای برتر را کسب کنند، حتی اگر محتوایشان بیارزش بود.

مثال واقعی (برای یک وبلاگ): در سال ۱۹۹۶، اگر یک وبلاگنویس میخواست برای عبارت «دستور پخت کیک شکلاتی» رتبه بگیرد، کافی بود مقالهای بنویسد و این عبارت را دهها بار در متن تکرار کند. حتی بدتر از آن، از تکنیکهایی مانند «متن نامرئی» استفاده میکرد؛ یعنی عبارت کلیدی را صدها بار در انتهای صفحه با رنگی مشابه رنگ پسزمینه مینوشت. برای کاربر نامرئی بود، اما خزنده موتور جستجو آن را میخواند. نتیجه؟ کاربر با یک صفحه بیکیفیت مواجه میشد و تجربه جستجو به شدت آسیب میدید.

اینجا بود که نیاز به یک راهکار هوشمندانهتر احساس میشد. راهکاری که نه تنها کلمات، بلکه «اعتبار» و «کیفیت» را نیز بسنجد و وب را دموکراتیک کند.

تولد یک غول: گوگل و انقلاب PageRank (۱۹۹۸-۲۰۰۸)

در سال ۱۹۹۸، دو دانشجوی دکترای دانشگاه استنفورد به نامهای لری پیج و سرگئی برین، با ارائه یک مقاله علمی با عنوان “The Anatomy of a Large-Scale Hypertextual Web Search Engine”، جهان جستجو را برای همیشه تغییر دادند. ایده مرکزی آنها الگوریتمی به نام PageRank بود.

PageRank چه بود؟ معرفی مفهوم «اعتبار» مبتنی بر لینک

ایده PageRank از دنیای آکادمیک الهام گرفته شده بود: همانطور که یک مقاله علمی که توسط مقالات معتبر زیادی به آن استناد (Cite) میشود، اهمیت بیشتری دارد، در دنیای وب نیز هر لینک به یک صفحه، مانند یک رأی اعتماد به آن صفحه است.

اما همه رأیها برابر نبودند. لینکی از یک صفحه معتبر (مانند وبسایت یک دانشگاه بزرگ که خودش PageRank بالایی داشت) وزن و ارزش بسیار بیشتری از لینکی از یک وبسایت ناشناخته داشت. این مفهوم «ارزش منتقل شده» یا Link Equity نام گرفت. گوگل با تحلیل ساختار لینکهای کل وب، به هر صفحه یک امتیاز اعتبار (PageRank) اختصاص میداد و از این امتیاز به عنوان یکی از مهمترین فاکتورها برای رتبهبندی استفاده میکرد. این یک انقلاب بود. دیگر صرفاً تکرار کلمات کلیدی کافی نبود؛ شما به «تأیید» دیگران نیاز داشتید.

این لحظه، نقطه تولد رسمی سئو به شکل مدرن آن بود. متخصصان وب به سرعت دریافتند که برای کسب رتبه در گوگل، باید دو کار اصلی انجام دهند:

- بهینهسازی محتوا (On-Page SEO): اطمینان از اینکه محتوای صفحه با کلمات کلیدی مورد نظر کاربر مرتبط است.

- لینکسازی (Off-Page SEO): دریافت لینکهای باکیفیت از وبسایتهای دیگر برای افزایش PageRank.

عصر طلایی سئوی کلاهسیاه: Keyword Stuffing و مزرعههای لینک

با اینکه PageRank یک گام بزرگ رو به جلو بود، اما هنوز هم قابل فریب بود. یک صنعت کامل حول محور دستکاری این الگوریتم شکل گرفت. متخصصان سئوی کلاهسیاه (Black-Hat SEO) به سرعت راههایی برای تولید مصنوعی «رأی اعتماد» پیدا کردند:

- خرید لینک (Paid Links): پرداخت پول به وبسایتها برای قرار دادن لینک در سایدبار، فوتر یا مقالات.

- مزرعه لینک (Link Farms): ایجاد شبکهای از وبسایتهای بیکیفیت که صرفاً برای لینک دادن به یکدیگر و متمرکز کردن PageRank به یک سایت اصلی (Money Site) ساخته شده بودند.

- کامنت اسپم (Comment Spam): استفاده از نرمافزارهای خودکار برای قراردادن لینک در بخش نظرات هزاران وبلاگ و انجمن.

- دایرکتوریهای مقالات (Article Directories): نوشتن مقالات بیکیفیت و ارسال آنها به صدها دایرکتوری فقط برای دریافت یک بکلینک.

اشتباهات رایج آن دوران: تمرکز بر کمیت به جای کیفیت

بزرگترین اشتباه در این دوره، تمرکز کورکورانه بر «تعداد» لینکها بود. استراتژی بسیاری از شرکتها این بود: «هرچقدر لینک بیشتر، بهتر!»، بدون اینکه به کیفیت یا مرتبط بودن سایت لینکدهنده توجهی کنند. ابزارهایی وجود داشتند که PageRank یک صفحه را به صورت یک نوار ابزار در مرورگر نمایش میدادند و تمام تمرکز سئوکاران بر افزایش این عدد بود. این استراتژی برای مدتی جواب میداد، اما گوگل در حال جمعآوری داده و آماده شدن برای یک پاکسازی بزرگ بود.

دوران پاکسازی بزرگ: گوگل علیه اسپم (۲۰۱۱-۲۰۱۲)

در اوایل دهه ۲۰۱۰، نتایج جستجوی گوگل به میدان جنگی از اسپم تبدیل شده بود. سایتهایی با محتوای ضعیف که با تکنیکهای لینکسازی مصنوعی به رتبههای بالا رسیده بودند، تجربه کاربری را به شدت مختل کرده بودند. اعتبار گوگل در خطر بود. پاسخ گوگل، دو بهروزرسانی الگوریتمی بزرگ و تکاندهنده بود که صنعت سئو را برای همیشه تغییر داد.

الگوریتم پاندا (Panda): جنگ با محتوای بیکیفیت و کپی

در فوریه ۲۰۱۱، الگوریتم پاندا عرضه شد. پاندا یک فیلتر کیفی بود که کل سایت را ارزیابی میکرد. هدف آن شناسایی و جریمه کردن سایتهایی با محتوای ضعیف (Thin Content)، کوتاه، کپی شده، تولید شده توسط ماشین، یا با تبلیغات بیش از حد بود. پاندا به سیگنالهای رفتار کاربر نیز توجه میکرد: آیا کاربران به سرعت دکمه بازگشت را میزنند؟ آیا این سایت توسط کاربران در نتایج جستجو بلاک میشود؟ سایتهایی که صرفاً برای کلمات کلیدی مختلف، صفحات بیارزش تولید میکردند (Content Farms)، یکشبه بخش بزرگی از ترافیک خود را از دست دادند.

مثال واقعی (برای یک فروشگاه اینترنتی): یک فروشگاه اینترنتی بزرگ را تصور کنید که برای صدها مدل کفش، توضیحات محصول یکسانی را از سایت تولیدکننده کپی کرده بود. قبل از پاندا، این صفحات ممکن بود رتبه خوبی داشته باشند. پس از پاندا، گوگل این صفحات را به عنوان محتوای تکراری و کمارزش شناسایی کرد و رتبه کل سایت را به شدت کاهش داد. راه حل؟ نوشتن توضیحات منحصربهفرد و کاربردی برای هر محصول، اضافه کردن نقد و بررسی کاربران و ارائه محتوای غنی مانند ویدئو.

الگوریتم پنگوئن (Penguin): مبارزه با لینکسازی اسپم و غیرطبیعی

یک سال بعد، در آوریل ۲۰۱۲، نوبت به الگوریتم پنگوئن رسید. هدف پنگوئن، پروفایل بکلینک سایتها بود. این الگوریتم به طور خاص سایتهایی را که با روشهای غیرطبیعی سعی در فریب PageRank داشتند، شناسایی و جریمه میکرد. پنگوئن به دنبال الگوهای مشکوک بود:

- لینکسازی با انکرتکستهای دقیق و تکراری (Exact Match Anchors): مثلاً هزاران لینک با انکرتکست «خرید لپتاپ ارزان».

- لینک از سایتهای نامرتبط: یک کلینیک دندانپزشکی که از یک وبلاگ شرطبندی لینک گرفته است.

- رشد ناگهانی و غیرطبیعی لینکها.

درس بزرگ پاندا و پنگوئن برای دنیای سئو این بود: دوران فریبکاری به پایان رسیده است. برای موفقیت بلندمدت در گوگل، باید روی کیفیت (هم در محتوا و هم در لینکسازی) و کسب اعتماد کاربر تمرکز کنید.

جعبهابزار: تحلیل بکلینک

برای اینکه بدانید چه سایتهایی به شما لینک دادهاند و از جریمه پنگوئن در امان بمانید، به ابزارهای تحلیل بکلینک نیاز دارید. این ابزارها به شما کمک میکنند لینکهای اسپم و مضر را شناسایی کنید.

- Ahrefs: یکی از کاملترین و دقیقترین پایگاههای داده بکلینک در جهان. (پولی)

- Semrush: یک مجموعه ابزار بازاریابی کامل که بخش تحلیل بکلینک قدرتمندی دارد. (پولی)

- Moz Link Explorer: یکی از قدیمیترین و معتبرترین ابزارها در این زمینه. (نسخه رایگان محدود)

- Google Search Console: ابزار رایگان خود گوگل که لیستی از لینکهای سایت شما را نشان میدهد.

نکته: اگر لینکهای اسپم زیادی به سایت شما اشاره میکنند، میتوانید از ابزار Google Disavow Tool برای بیاثر کردن آنها استفاده کنید. این کار به گوگل میگوید که این لینکها را هنگام ارزیابی سایت شما نادیده بگیرد.

انقلاب معنایی: گوگل شروع به درک میکند (۲۰۱۳-۲۰۱۵)

پس از پاکسازی اسپم، گوگل وارد فاز جدیدی شد: درک معنا و قصد کاربر. گوگل دیگر نمیخواست یک موتور تطبیق کلمات کلیدی باشد؛ بلکه میخواست به یک «موتور پاسخ» تبدیل شود که موجودیتها (Entities)، مفاهیم و روابط بین آنها را درک میکند.

الگوریتم مرغ مگسخوار (Hummingbird): فراتر از کلمات کلیدی، درک «قصد کاربر»

در سال ۲۰۱۳، الگوریتم مرغ مگسخوار (Hummingbird) کل موتور جستجوی گوگل را بازنویسی کرد. این بهروزرسانی به گوگل اجازه داد تا کوئریهای طولانی و مکالمهای (Conversational Queries) را بهتر درک کند. به جای تمرکز بر کلمات مجزا، مرغ مگسخوار به مفهوم کلی جمله و «قصد» پشت آن توجه میکرد. این الگوریتم با کمک گراف دانش (Knowledge Graph)، که پایگاه داده عظیمی از موجودیتها و روابط بین آنهاست، کار میکرد.

برای مثال، قبل از مرغ مگسخوار، اگر شما جستجو میکردید «پایتخت فرانسه کجاست؟»، گوگل به دنبال صفحاتی بود که این کلمات را داشتند. اما پس از این الگوریتم، گوگل «پاریس» را به عنوان یک «موجودیت» و «پایتخت بودن» را به عنوان یک «رابطه» با موجودیت «فرانسه» درک میکرد و میتوانست پاسخ مستقیم را در بالای نتایج نمایش دهد.

الگوریتم کبوتر (Pigeon) و اهمیت سئوی محلی (Local SEO)

در سال ۲۰۱۴، الگوریتم کبوتر (Pigeon) نتایج جستجوی محلی را به شدت تحت تاثیر قرار داد. این الگوریتم سیگنالهای رتبهبندی وب سنتی را با سیگنالهای محلی (مانند موقعیت مکانی کاربر، فاصله کسبوکار، و اطلاعات Google Maps) ترکیب کرد. پس از کبوتر، داشتن یک پروفایل بهینه در Google My Business (که اکنون Google Business Profile نامیده میشود) و دریافت نظرات مثبت از مشتریان محلی، برای کسبوکارهایی مانند رستورانها، فروشگاهها و پزشکان حیاتی شد.

مثال واقعی (برای یک پرتال خبری): یک سایت خبری را در نظر بگیرید. قبل از مرغ مگسخوار، این سایت برای رتبه گرفتن روی «قیمت دلار امروز»، باید دقیقاً همین عبارت را در تیتر و متن خود تکرار میکرد. پس از آن، گوگل درک میکند که کوئریهایی مانند «یک دلار چند تومان است؟» یا «نرخ ارز امروز» همگی یک قصد دارند و ممکن است همان مقاله را برای همه این جستجوها نشان دهد. این تغییر، تمرکز را از «بهینهسازی برای کلمه کلیدی» به «پوشش کامل یک موضوع» تغییر داد.

عصر هوش مصنوعی و تجربه کاربری (۲۰۱۵-۲۰۲۴)

از سال ۲۰۱۵، هوش مصنوعی (AI) و یادگیری ماشین (Machine Learning) به هسته مرکزی الگوریتمهای گوگل تبدیل شدند. هدف، شخصیسازی و بهبود مستمر نتایج بر اساس تحلیل دادههای عظیم و رفتار کاربران بود.

RankBrain: اولین الگوریتم مبتنی بر هوش مصنوعی

در سال ۲۰۱۵، گوگل RankBrain را معرفی کرد؛ یک سیستم یادگیری ماشین که به گوگل کمک میکرد کوئریهای کاملاً جدید و مبهم (حدود ۱۵٪ از جستجوهای روزانه) را بهتر درک کند. RankBrain به گوگل کمک میکند بهترین صفحات موجود را برای یک کوئری مبهم حدس بزند، نتایج را به کاربر نشان دهد و سپس بر اساس سیگنالهای تعامل کاربر (نرخ کلیک، زمان ماندگاری و…) یاد بگیرد که آیا حدسش درست بوده یا نه. این سیستم به طور مداوم و خودکار خود را بهبود میبخشد.

Mobile-First Indexing: وقتی موبایل به اولویت اول گوگل تبدیل شد

با افزایش چشمگیر استفاده از گوشیهای هوشمند برای وبگردی، گوگل در سال ۲۰۱۸ رسماً اعلام کرد که به سیستم Mobile-First Indexing روی میآورد. این یعنی گوگل دیگر نسخه دسکتاپ وبسایت شما را به عنوان نسخه اصلی در نظر نمیگیرد؛ بلکه نسخه موبایل سایت شما را میخزد، ایندکس میکند و برای رتبهبندی معیار قرار میدهد. از این لحظه به بعد، داشتن یک وبسایت واکنشگرا (Responsive) یا یک نسخه موبایل بهینه، دیگر یک انتخاب نبود، بلکه یک ضرورت مطلق بود.

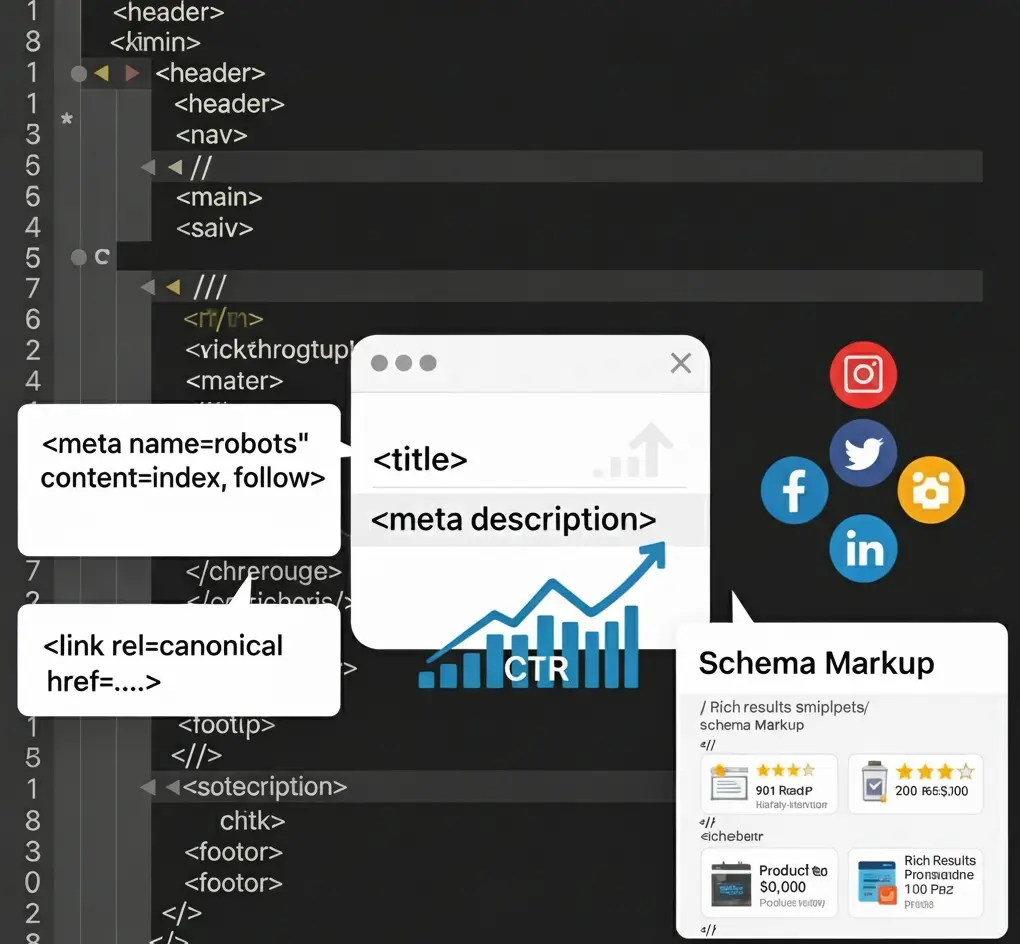

E-A-T و E-E-A-T: اهمیت تخصص، تجربه، اعتبار و اعتماد

گوگل در راهنمای ارزیابان کیفیت جستجوی خود (Search Quality Rater Guidelines)، مفهومی به نام E-A-T را معرفی کرد که مخفف Expertise (تخصص)، Authoritativeness (اعتبار) و Trustworthiness (اعتماد) بود. این معیارها، به خصوص برای سایتهای حوزه YMYL (Your Money or Your Life) – سایتهایی که محتوای آنها میتواند بر سلامت، ایمنی یا وضعیت مالی کاربران تأثیر بگذارد (مانند سایتهای پزشکی، مالی و حقوقی) – اهمیت فوقالعادهای دارند.

در دسامبر ۲۰۲۲، گوگل یک «E» دیگر به این مفهوم اضافه کرد و آن را به E-E-A-T تبدیل کرد:

- Experience (تجربه): آیا نویسنده محتوا، تجربه دست اول و واقعی از موضوع دارد؟ (مثلاً نقد یک محصول توسط کسی که واقعاً از آن استفاده کرده).

- Expertise (تخصص): آیا نویسنده دانش و مهارت لازم در آن زمینه را دارد؟ (مدارک تحصیلی، سوابق شغلی، مقالات علمی).

- Authoritativeness (اعتبار): آیا نویسنده و وبسایت به عنوان یک مرجع معتبر در آن صنعت شناخته میشوند؟ (لینکها و اشارات از سایتهای معتبر).

- Trustworthiness (اعتماد): آیا وبسایت امن (HTTPS)، شفاف (صفحات درباره ما و تماس با ما) و قابل اعتماد است؟

Core Web Vitals: تجربه کاربری به عنوان یک فاکتور مستقیم رتبهبندی

در سال ۲۰۲۱، گوگل با معرفی Core Web Vitals، تجربه کاربری (UX) را به یک فاکتور رتبهبندی مستقیم تبدیل کرد. این سه معیار فنی، تجربه بارگذاری و تعامل کاربر با صفحه را میسنجند:

- LCP (Largest Contentful Paint): سرعت بارگذاری بزرگترین عنصر در صفحه.

- INP (Interaction to Next Paint): سرعت پاسخدهی کلی صفحه به تعاملات کاربر (این معیار جایگزین FID شده است).

- CLS (Cumulative Layout Shift): پایداری بصری صفحه (جلوگیری از جابجایی ناگهانی عناصر).

این بهروزرسانی، پیام واضحی داشت: سایتی که کند باشد یا تجربه کاربری بدی ارائه دهد، حتی با بهترین محتوا هم شانس کمتری برای کسب رتبههای برتر خواهد داشت.

| جدول مقایسهای: سئوی دیروز در مقابل سئوی امروز | |

|---|---|

| سئوی دیروز (تا حدود ۲۰۱۲) | سئوی امروز (۲۰۲۵) |

| تمرکز بر کلمات کلیدی | تمرکز بر موضوعات و قصد کاربر |

| معیار اصلی: تعداد لینکها (PageRank) | معیار اصلی: کیفیت، تجربه و اعتماد (E-E-A-T) |

| هدف: فریب موتور جستجو | هدف: رضایت و کمک به کاربر |

| تاکتیک: Keyword Stuffing، خرید لینک | تاکتیک: تولید محتوای عمیق، لینکسازی طبیعی، بهینهسازی UX |

| پلتفرم: اولویت با دسکتاپ | پلتفرم: اولویت مطلق با موبایل (Mobile-First) |

آینده جستجو: عصر مکالمه و تولید (۲۰۲۵ و فراتر)

تکامل هرگز متوقف نمیشود. ما اکنون در آستانه یک تحول بزرگ دیگر در دنیای جستجو هستیم: عصر هوش مصنوعی مولد.

BERT و مدلهای زبانی بزرگ: درک عمیقتر زبان انسان

قبل از اینکه به آینده بپردازیم، باید به BERT (۲۰۱۹) اشاره کنیم؛ یک مدل زبانی پیشرفته که به گوگل کمک کرد تا ظرافتها و پیچیدگیهای زبان انسان، به خصوص حروف اضافه و کلمات ربط، را در کوئریها بهتر درک کند. BERT و مدلهای زبانی بزرگ (LLMs) که پس از آن آمدند، زیرساخت اصلی برای انقلاب بعدی بودند.

تجربه جستجوی مولد (SGE): وقتی گوگل خودش پاسخ را «تولید» میکند

Search Generative Experience (SGE)، پروژه جدید گوگل است که هوش مصنوعی مولد را مستقیماً وارد صفحه نتایج جستجو (SERP) میکند. در این سیستم، به جای اینکه فقط لیستی از ۱۰ لینک آبی به شما نمایش داده شود، گوگل با استفاده از اطلاعات موجود در وب، یک پاسخ جامع، خلاصهشده و تولید شده توسط هوش مصنوعی را در بالای نتایج به شما ارائه میدهد.

این سیستم میتواند برای کوئریهای پیچیده، یک «snapshot» یا خلاصهی هوشمند ایجاد کند، به شما اجازه دهد سوالات تکمیلی بپرسید و یک مکالمه با موتور جستجو داشته باشید.

سئو در عصر SGE: چگونه باید استراتژی خود را تغییر دهیم؟

آیا SGE به معنای مرگ سئو است؟ قطعاً نه. اما به معنای تکامل سئو است. در دنیای SGE:

- اهمیت E-E-A-T چند برابر میشود: گوگل برای تولید پاسخهای خود، به معتبرترین و قابل اعتمادترین منابع استناد خواهد کرد. هدف جدید سئو، تبدیل شدن به یکی از همان منابعی است که هوش مصنوعی به آن استناد میکند.

- تمرکز بر کوئریهای بسیار خاص و طولانی (Long-Tail) بیشتر میشود: کاربر ممکن است پاسخهای عمومی را از SGE بگیرد، اما برای سوالات عمیق، تخصصی و نیازمند تجربه واقعی، همچنان به وبسایت شما مراجعه خواهد کرد. محتوای شما باید به سوالاتی پاسخ دهد که پاسخ سادهای ندارند.

- برندسازی و ایجاد کامیونیتی حیاتی است: شما باید کاری کنید که کاربران مستقیماً به دنبال برند شما بگردند (Navigational Queries)، نه اینکه صرفاً از طریق جستجوی عمومی با شما آشنا شوند. ترافیک مستقیم و وفاداری به برند، ارزشمندتر از همیشه خواهد بود.

سوالات متداول (FAQ)

۱. آیا سئوی کلاهسیاه هنوز هم کار میکند؟ ممکن است برای مدت کوتاهی نتایج مثبتی به همراه داشته باشد، اما ریسک آن بسیار بالاست. الگوریتمهای گوگل روزبهروز هوشمندتر میشوند و جریمه شدن توسط آنها (چه به صورت الگوریتمی و چه از طریق جریمه دستی) میتواند کسبوکار شما را برای همیشه نابود کند. سئوی پایدار، همیشه بر پایه اصول کلاهسفید (White-Hat) و تمرکز بر کاربر است.

۲. مهمترین فاکتور رتبهبندی گوگل در حال حاضر چیست؟ هیچ «یک» فاکتور جادویی وجود ندارد. گوگل از صدها سیگنال مختلف استفاده میکند. امروزه از «سئوی کلنگر» (Holistic SEO) صحبت میشود که در آن، محتوای باکیفیت و مرتبط (که E-E-A-T را نشان میدهد)، یک تجربه کاربری عالی (فنی و بصری) و یک پروفایل بکلینک طبیعی و معتبر، همگی با هم کار میکنند تا اعتماد گوگل و کاربر را جلب کنند.

۳. یادگیری سئو را از کجا شروع کنم؟ بهترین نقطه شروع، مستندات رسمی خود گوگل (Google Search Central) است. سپس میتوانید از منابع معتبری مانند وبلاگهای Moz, Ahrefs, Search Engine Land و البته وبسایت خود من، mortezaazimi.ir، برای یادگیری تکنیکهای عملی و پیشرفته استفاده کنید.

۴. آیا SGE باعث کاهش ترافیک ارگانیک سایتها خواهد شد؟ احتمالاً برای برخی کوئریهای اطلاعاتی ساده (Information Queries) که پاسخ آنها یک حقیقت مشخص است (مانند «ارتفاع برج ایفل»)، ترافیک کاهش یابد. اما برای کوئریهای پیچیده، تجاری (Commercial) و تراکنشی (Transactional)، کاربران همچنان نیاز دارند به وبسایتهای تخصصی مراجعه کنند. کلید موفقیت، تطبیق استراتژی و تمرکز بر ارائه ارزشی است که هوش مصنوعی مولد به تنهایی قادر به ارائه آن نیست (مانند تجربه واقعی، تحلیل عمیق و ایجاد اعتماد).

نتیجهگیری: چکلیست نهایی پیادهسازی سئو مدرن

سفر ما از دایرکتوریهای دستی تا جستجوی مولد نشان میدهد که یک اصل همیشه ثابت بوده است: موتورهای جستجو در تلاشند تا بهترین و مرتبطترین پاسخ را به کاربر ارائه دهند. سئو، هنر و علم همسو کردن وبسایت شما با همین هدف است. این یک بازی موش و گربه نیست؛ یک همکاری استراتژیک است.

حالا نوبت شماست. از این چکلیست استفاده کنید تا وبسایت خود را بر اساس اصول سئوی مدرن ارزیابی و بهینه کنید:

- ارزیابی E-E-A-T:

- آیا صفحات «درباره ما» و «نویسندگان» شما کامل و شفاف هستند؟

- آیا برای نویسندگان خود بیوگرافیهای دقیق با ذکر تخصص و سوابقشان ایجاد کردهاید؟

- آیا تخصص و تجربه خود را با مدارک، مطالعات موردی و نظرات مشتریان اثبات کردهاید؟

- بهینهسازی برای قصد کاربر:

- آیا قبل از تولید محتوا، تحقیق میکنید که کاربر با جستجوی یک عبارت به دنبال چه نوع محتوایی است (اطلاعات، خرید، مقایسه)؟

- آیا محتوای شما به طور کامل نیاز و سوالات پنهان کاربر را پوشش میدهد؟

- اولویت با موبایل:

- آیا سایت شما در دستگاههای موبایل سریع، خوانا و کاربرپسند است؟ (از ابزار Mobile-Friendly Test گوگل استفاده کنید).

- آیا از پاپآپهای مزاحم در نسخه موبایل خودداری میکنید؟

- بررسی Core Web Vitals:

- آیا سرعت بارگذاری و پایداری بصری سایت شما قابل قبول است؟ (گزارش Core Web Vitals را در سرچ کنسول بررسی کنید).

- آیا تصاویر خود را بهینه کرده و از هاستینگ پرسرعت استفاده میکنید؟

- تحلیل پروفایل بکلینک:

- آیا لینکهای شما از منابع معتبر و مرتبط میآیند؟

- آیا به طور منظم پروفایل بکلینک خود را برای شناسایی لینکهای اسپم بررسی میکنید؟

- آمادگی برای آینده:

- آیا در حال تولید محتوایی هستید که تجربههای دست اول، تحلیلهای عمیق و دیدگاههای منحصربهفرد ارائه میدهد؟ محتوایی که هوش مصنوعی نمیتواند به سادگی آن را بازتولید کند.

این مسیر، یک مسیر دائمی از یادگیری و انطباق است. امیدوارم این راهنمای تاریخی و تحلیلی، دید بهتری از «چرا»ی سئو به شما داده باشد.

برای دریافت آموزشهای پیشرفتهتر و استراتژیهای عملی، حتماً به وبسایت من mortezaazimi.ir سر بزنید. موفق باشید.