مقدمه: چرا باید الگوریتمهای گوگل را مثل کف دست بشناسیم؟

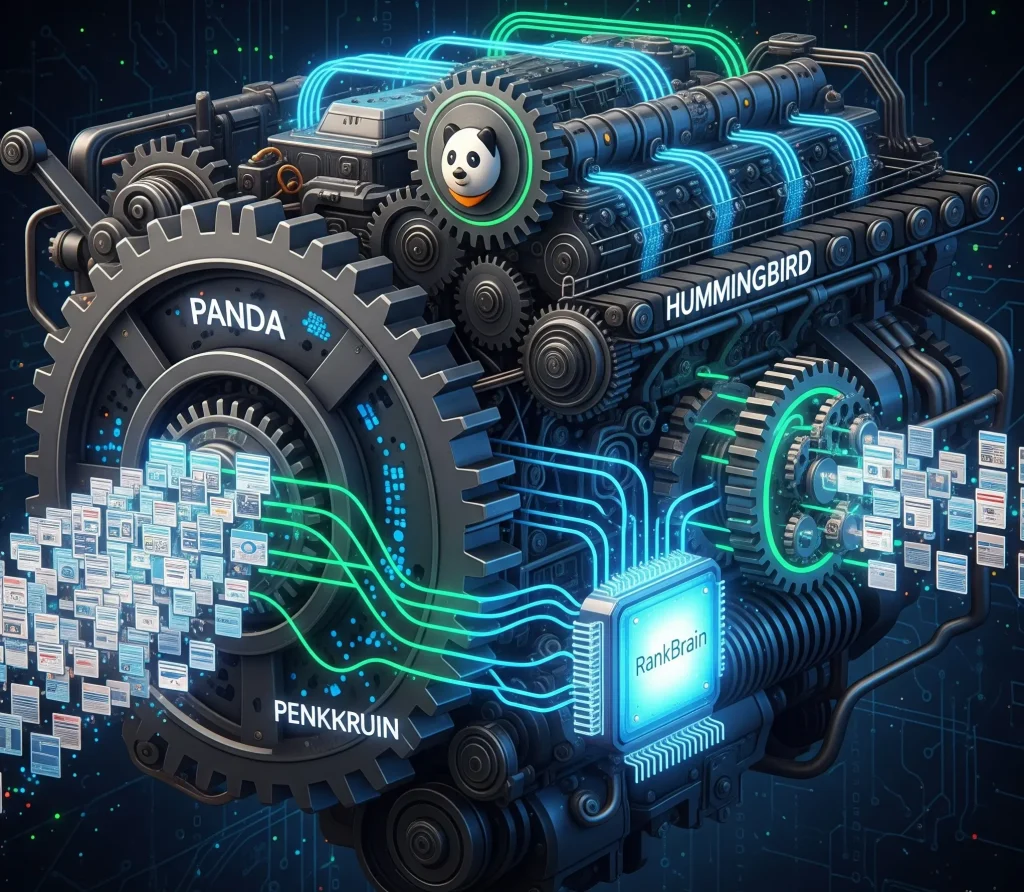

سلام! من مرتضی عظیمی هستم و در این راهنمای جامع، قصد دارم شما را به یک سفر عمیق در دنیای الگوریتمهای گوگل ببرم. اگر در دنیای دیجیتال فعالیت میکنید، حتماً نامهایی مانند پاندا، پنگوئن یا آپدیتهای هسته را شنیدهاید. اینها فقط اسامی عجیب و غریب نیستند؛ آنها قوانین نانوشته و پویای بازی در دنیای جستجو هستند. الگوریتمهای گوگل، سیستمهای هوشمند و چندلایهای هستند که با تحلیل صدها فاکتور، تصمیم میگیرند کدام وبسایت برای کدام جستجو، شایستگی قرار گرفتن در رتبههای برتر را دارد.

نشناختن این الگوریتمها مانند تلاش برای ساختن یک آسمانخراش بدون اطلاع از قوانین فیزیک و مهندسی است. ممکن است در ابتدا چند طبقه را بالا ببرید، اما دیر یا زود با مشکلات ساختاری بنیادین و جریمههای سنگین (افت ناگهانی رتبه و ترافیک) مواجه خواهید شد که میتواند تمام زحمات شما را به باد دهد. در مقابل، درک عمیق این الگوریتمها به شما یک نقشه راه استراتژیک میدهد. این درک به شما قدرت میدهد که نه تنها از جریمهها در امان بمانید، بلکه با گوگل به عنوان یک شریک همکاری کنید، نیازهایش را پیشبینی کرده و با استراتژیهای هوشمندانه، رقبای خود را پشت سر بگذارید و به جایگاههای برتر گوگل دست یابید. این دانش، تفاوت بین یک استراتژی سئوی واکنشی (که مدام در حال جبران خسارت است) و یک استراتژی سئوی پیشرو (که برای آینده آماده میشود) را رقم میزند.

این راهنما برای چه کسانی است؟

این راهنما برای یک طیف گسترده از فعالان وب که به دنبال رشد پایدار هستند، طراحی شده است:

- متخصصان سئو و مدیران دیجیتال مارکتینگ: که میخواهند فراتر از تکنیکهای سطحی رفته، دانش خود را عمیقتر کنند و بتوانند با اطمینان، نوسانات ترافیک را برای مدیران ارشد خود تحلیل و استراتژیهای آینده را تدوین کنند.

- صاحبان کسبوکارهای آنلاین: که میخواهند از سردرگمی خارج شوند، دلیل واقعی نوسان ترافیک سایتشان را بفهمند و با دیدی باز، سرمایهگذاریهای خود در حوزه محتوا و سئو را مدیریت کنند تا به رشد پایدار و قابل پیشبینی دست یابند.

- تولیدکنندگان محتوا و وبمسترها: که به دنبال خلق محتوا و ساختاری هستند که نه تنها از نظر فنی بهینه باشد، بلکه عمیقاً مورد علاقه گوگل و کاربران قرار گیرد و به عنوان یک منبع معتبر در وب شناخته شود.

- دانشجویان و علاقهمندان به دنیای سئو: که میخواهند مفاهیم پایه را به شکلی کاربردی، عمیق و به دور از اطلاعات تاریخ مصرف گذشته یاد بگیرند و یک بنیاد محکم برای شروع فعالیت حرفهای خود بسازند.

چه چیزی یاد خواهید گرفت؟

- هدف و تاریخچه: با داستان، فلسفه و دلیل به وجود آمدن هر یک از الگوریتمهای کلیدی گوگل آشنا میشوید تا بتوانید “افق دید” گوگل را درک کنید.

- تاثیرات عملی: به صورت دقیق درک میکنید که هر الگوریتم چه سیگنالهایی را در وبسایت شما (از کیفیت یک پاراگراف تا ساختار بکلینکها) بررسی میکند.

- استراتژیهای بهینهسازی: راهکارهای عملی، چکلیستهای کاربردی و گامبهگام برای همسو شدن با هر الگوریتم را یاد میگیرید.

- پیشگیری و درمان: میآموزید چگونه با ساخت یک وبسایت باکیفیت از جریمههای الگوریتمی جلوگیری کرده و در صورت افت رتبه، یک برنامه مدون و موثر برای بازیابی سایت خود طراحی کنید.

نگاهی سریع به الگوریتمهای کلیدی گوگل

| الگوریتم | سال معرفی | تمرکز اصلی | هدف |

|---|---|---|---|

| پاندا (Panda) | ۲۰۱۱ | کیفیت محتوا | مبارزه با محتوای سطحی، تکراری و بیارزش |

| پنگوئن (Penguin) | ۲۰۱۲ | کیفیت بکلینکها | مبارزه با لینکسازی اسپم و پروفایل لینک غیرطبیعی |

| مرغمگسخوار (Hummingbird) | ۲۰۱۳ | جستجوی معنایی | درک هدف پشت کوئریهای محاورهای و طولانی |

| رنکبرین (RankBrain) | ۲۰۱۵ | هوش مصنوعی و UX | درک کوئریهای جدید و تحلیل رفتار کاربر |

| برت (BERT) | ۲۰۱۹ | پردازش زبان طبیعی | درک ظرافتها و روابط بین کلمات در یک جمله |

| آپدیت هسته (Core Update) | دورهای | کیفیت کلی سایت | ارزیابی جامع سایت بر اساس E-E-A-T |

| محتوای مفید (Helpful Content) | ۲۰۲۲ | اصالت و رضایت کاربر | پاداش به محتوای ساخته شده برای انسان و جریمه محتوای سئومحور |

تاریخچه و تکامل الگوریتمهای گوگل: از یک موتور جستجوی ساده تا یک ماشین پاسخگویی

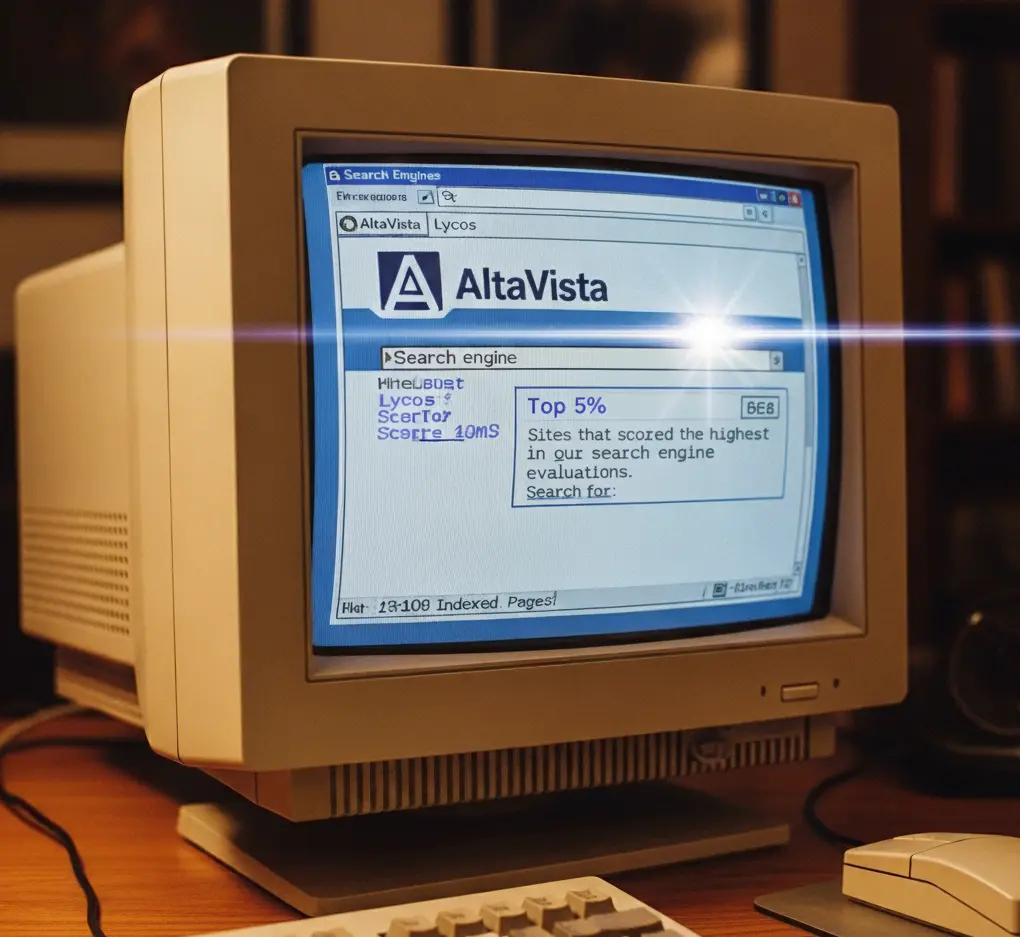

در روزهای اولیه اینترنت، که میتوان آن را “غرب وحشی سئو” نامید، موتورهای جستجو بسیار ساده و قابل فریب بودند. الگوریتمها عمدتاً بر اساس تراکم کلمات کلیدی (Keyword Density) کار میکردند. وبمسترها از تکنیکهایی مانند متن نامرئی (نوشتن کلمات کلیدی با رنگ پسزمینه)، صفحات دروازه (Doorway Pages) (صفحات بیکیفیتی که فقط برای رتبه گرفتن در یک کلمه کلیدی ساخته شده و کاربر را به صفحه دیگری هدایت میکردند) و بمباران کلمات کلیدی برای کسب رتبه استفاده میکردند. این روش به سرعت منجر به ظهور صفحات اسپم و بیکیفیتی شد که هیچ ارزشی برای کاربر نداشتند و تجربه جستجو را به شدت مخدوش کرده بودند.

رقص گوگل (Google Dance) و دوران پیشا-الگوریتم

در اوایل دهه ۲۰۰۰، گوگل به صورت ماهانه ایندکس خود را بهروزرسانی میکرد. این بهروزرسانیها که چند روز طول میکشید، باعث نوسانات شدید در نتایج جستجو میشد و وبمسترها به آن لقب “رقص گوگل” داده بودند. اما مشکل اصلی همچنان پابرجا بود: سیستم به راحتی قابل دستکاری بود و گوگل از یک “سیستم بازیابی اسناد” به یک “موتور پاسخگویی” که هدفش درک عمیق نیاز کاربر است، فاصله زیادی داشت.

نیاز به نظم: تولد الگوریتمهای هوشمند برای مبارزه با اسپم

گوگل برای حفظ اعتبار خود و تبدیل شدن به منبع اصلی اطلاعات در وب، نیاز به سیستمهای هوشمندتری داشت. این نیاز، منجر به تولد الگوریتمهایی شد که هر کدام برای مبارزه با یک نوع خاص از اسپم یا محتوای بیکیفیت طراحی شده بودند. این الگوریتمها دیگر فقط به کلمات کلیدی نگاه نمیکردند، بلکه دهها و حتی صدها سیگنال مختلف، از سرعت بارگذاری صفحه گرفته تا اعتبار دامنه لینکدهنده را برای ارزیابی کیفیت یک صفحه در نظر میگرفتند. این آغاز یک تکامل بیپایان به سوی درک کیفیت، درست مانند یک انسان، بود.

الگوریتم پاندا (Panda): نگهبان محتوای باکیفیت

تاریخ معرفی: ۲۰۱۱

الگوریتم پاندا اولین زنگ خطر جدی و اولین گام بزرگ گوگل برای پاکسازی وب از محتوای بیکیفیت بود. این الگوریتم مانند یک کتابدار سختگیر و باتجربه، کل وب را بررسی کرد تا کتابهای (صفحات) بیارزش، کپیشده و سطحی را از قفسههای اصلی (صفحه اول نتایج جستجو) حذف کند.

پاندا چه مشکلی را حل کرد؟

قبل از پاندا، پدیدهای به نام “مزارع محتوا” (Content Farms) بسیار رایج بود. این وبسایتها با استخدام ارتشی از نویسندگان ارزانقیمت، روزانه هزاران مقاله کوتاه و سطحی در مورد هر موضوع قابل تصوری تولید میکردند، فقط برای اینکه در کلمات کلیدی زیادی رتبه بگیرند. این محتواها هیچ ارزش واقعی برای کاربر نداشتند. پاندا دقیقاً برای مبارزه با این نوع وبسایتها و همچنین محتوای بیکیفیت (Thin Content)، محتوای کپی شده و محتوای تولید شده توسط ماشین طراحی شد.

سیگنالهای کلیدی برای پاندا: کیفیت، تکرار و ارزش افزوده

پاندا به دنبال سیگنالهایی است که نشاندهنده کیفیت پایین یک صفحه یا کل سایت هستند:

- محتوای کوتاه و سطحی (Thin Content): صفحاتی که اطلاعات بسیار کمی دارند (مثلاً یک مقاله ۲۰۰ کلمهای در مورد یک موضوع پیچیده) و به سوال کاربر پاسخ کاملی نمیدهند.

- محتوای تکراری (Duplicate Content): وجود محتوای یکسان در صفحات مختلف سایت شما (تکرار داخلی) یا کپی کردن محتوا از سایتهای دیگر (تکرار خارجی). این موضوع به خصوص در سایتهای فروشگاهی که از توضیحات یکسان برای محصولات مشابه استفاده میکنند، رایج است.

- تجربه کاربری ضعیف: صفحاتی که پر از تبلیغات پاپ-آپ و بنرهای مزاحم هستند، طراحی گیجکنندهای دارند و کاربر را در پیدا کردن اطلاعات مورد نیازش سردرگم میکنند.

- عدم وجود E-E-A-T: محتوایی که توسط افراد غیرمتخصص نوشته شده، فاقد منابع معتبر است و نمیتوان به اطلاعات آن اعتماد کرد.

- نرخ پرش بالا (High Bounce Rate): اگر کاربران پس از ورود به صفحه شما، به سرعت دکمه بازگشت را میزنند، این یک سیگنال قوی به گوگل است که صفحه شما نتوانسته نیاز آنها را برآورده کند.

استراتژیهای عملی برای انطباق با پاندا (چکلیست)

برای اینکه سایت شما مورد علاقه پاندا باشد، این چکلیست را دنبال کنید:

- آیا محتوای شما اصیل و منحصر به فرد است؟ (از ابزارهایی مانند Copyscape برای بررسی استفاده کنید)

- آیا محتوای شما جامع و کامل است و به تمام سوالات احتمالی کاربر پاسخ میدهد؟

- آیا محتوای شما توسط یک فرد متخصص در آن حوزه نوشته شده است؟ (صفحه “درباره ما” و بیوگرافی نویسنده قوی ایجاد کنید)

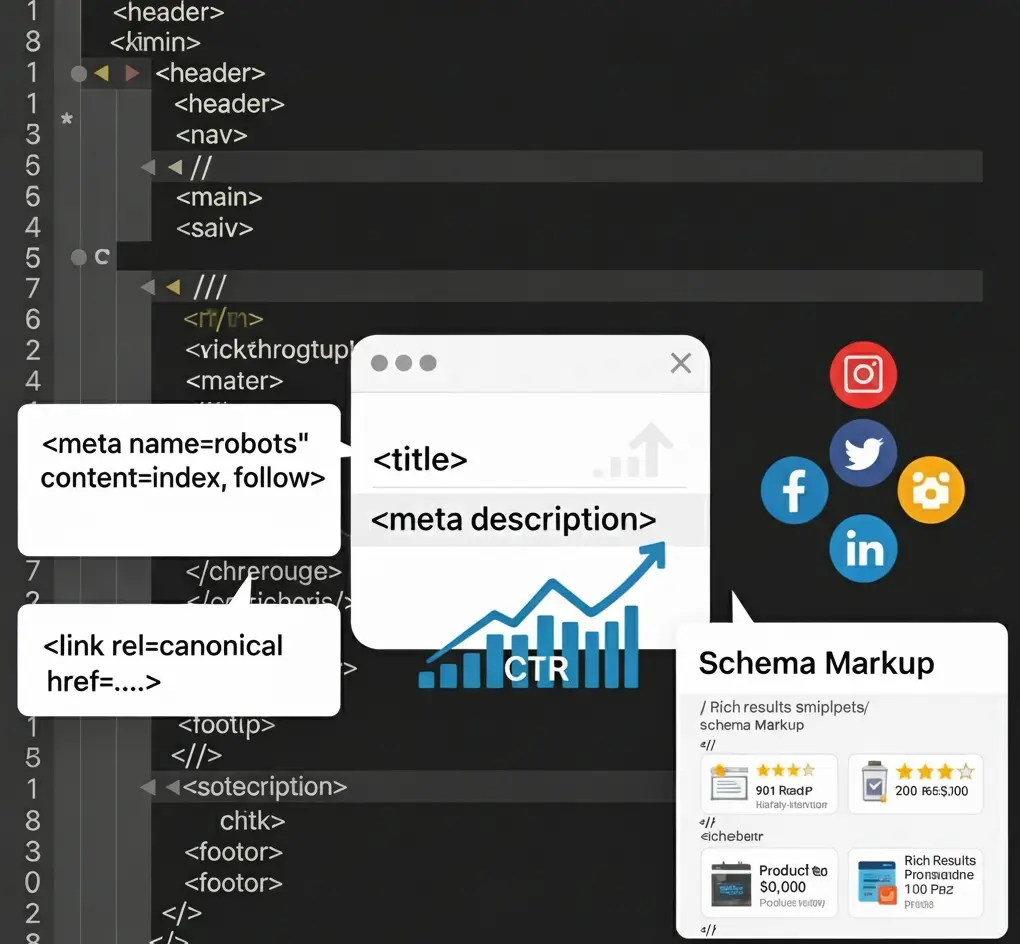

- آیا سایت شما از نظر فنی سالم است و محتوای تکراری داخلی (Internal Duplicate Content) ندارد؟ (از تگ کنونیکال به درستی استفاده کنید)

- آیا تعداد تبلیغات در صفحه منطقی است و تجربه کاربری را مختل نمیکند؟

- آیا محتوای خود را به طور منظم بهروزرسانی میکنید تا اطلاعات آن تازه و دقیق باقی بماند؟

اشتباهات رایج در مورد پاندا

- “فقط باید محتوای طولانی بنویسم.” خیر! کیفیت مهمتر از کمیت است. یک مقاله ۱۰۰۰ کلمهای عمیق و کاربردی که یک مشکل واقعی را حل میکند، بسیار بهتر از یک مقاله ۳۰۰۰ کلمهای سطحی است که صرفاً برای طولانی شدن، حاشیهروی میکند.

- “پاندا فقط به یک صفحه نگاه میکند.” اشتباه است. پاندا یک ارزیابی کلی و در سطح سایت (Site-wide) از کیفیت محتوای شما دارد. وجود تعداد زیادی صفحه بیکیفیت میتواند بر رتبه کل سایت شما، حتی صفحات باکیفیت، تأثیر منفی بگذارد.

- “باید تمام صفحات کوتاه را حذف کنم.” این نیز یک تصور غلط است. برخی صفحات ذاتاً کوتاه هستند (مانند صفحات تماس با ما یا واژهنامه). نکته کلیدی، “ارزش” است نه “طول”. اگر یک صفحه کوتاه، ارزشمند و کاربردی است، مشکلی ایجاد نخواهد کرد.

مثالهای واقعی

- وبسایت بلاگ: یک وبلاگ آشپزی که صدها دستور پخت کوتاه و کپی شده از سایتهای دیگر دارد، توسط پاندا جریمه میشود. راه حل: انجام یک “ممیزی محتوا”. حذف دستورهای ضعیف، ادغام دستورهای مشابه در یک راهنمای جامع (مثلاً “۲۰ نوع کوکوی ایرانی با تمام فوت و فنها”) همراه با تصاویر اصلی و ویدیو.

- فروشگاه اینترنتی: یک فروشگاه که برای تمام مدلهای یک برند کفش، از توضیحات تکراری ارائه شده توسط تولیدکننده استفاده میکند. راه حل: نوشتن توضیحات محصول منحصر به فرد برای هر کفش با تمرکز بر مزایا، مواد به کار رفته، کاربردها (مناسب برای دویدن یا پیادهروی؟) و اضافه کردن بخش نقد و بررسی دقیق کاربران.

- وبسایت خبری: یک پورتال خبری که صرفاً اخبار را از خبرگزاریهای دیگر بازنشر میکند، بدون هیچ تحلیل یا گزارش اختصاصی. راه حل: تمرکز بر گزارشهای تحقیقی، مصاحبههای اختصاصی، برگزاری میزگردهای تحلیلی با کارشناسان و ارائه دیدگاههای منحصر به فرد در مورد اخبار روز.

الگوریتم پنگوئن (Penguin): پلیس لینکهای اسپم

تاریخ معرفی: ۲۰۱۲

اگر پاندا کتابدار بود، پنگوئن یک کارآگاه تیزبین و متخصص جرمشناسی دیجیتال است که به دنبال ردپای مجرمان در دنیای لینکسازی میگردد. هدف اصلی پنگوئن، مبارزه با بکلینکهای اسپم، پروفایلهای لینک غیرطبیعی و تلاش برای دستکاری PageRank بود.

پنگوئن با چه چیزی مبارزه میکند؟

قبل از پنگوئن، خرید بستههای هزارتایی بکلینک، ثبت لینک در کامنتهای وبلاگها با انکرتکستهای دقیق و استفاده از شبکههای وبلاگی خصوصی (PBN) یک استراتژی رایج و متاسفانه موثر بود. وبمسترها سعی داشتند با ایجاد لینکهای مصنوعی، گوگل را فریب دهند که سایتشان محبوب و معتبر است. پنگوئن برای شناسایی، بیاثر کردن (و در مواردی جریمه کردن) این لینکها و سایتهایی که از آنها بهره میبردند، به وجود آمد.

نشانههای یک پروفایل بکلینک سمی

- لینک از سایتهای غیرمرتبط: یک سایت آشپزی که از یک سایت فروش قطعات خودرو با انکرتکست “بهترین دستور پخت قورمه سبزی” لینک گرفته است.

- لینک از سایتهای اسپم یا جریمه شده: لینکهایی که از مزارع لینک (Link Farms)، سایتهای شرطبندی یا سایتهای با محتوای بزرگسالان میآیند.

- استفاده بیش از حد از انکر تکست کلمه کلیدی: اگر ۹۰٪ بکلینکهای شما با انکر تکست “خرید گوشی سامسونگ” باشد، این یک سیگنال خطر بزرگ و غیرطبیعی است. پروفایل انکرتکست طبیعی باید شامل نام برند، URL، و عبارات عمومی (مانند “اینجا کلیک کنید”) نیز باشد.

- رشد ناگهانی و غیرطبیعی تعداد بکلینکها: افزایش هزاران بکلینک در یک شب، فریاد میزند که این لینکها خریداری شدهاند.

- لینکهای پولی که به عنوان

nofollowیاsponsoredعلامتگذاری نشدهاند. - لینکهای Sitewide: لینکهایی که در فوتر یا سایدبار یک سایت قرار دارند و در تمام صفحات آن تکرار میشوند، اغلب ارزش کمی دارند و میتوانند به عنوان اسپم تلقی شوند.

راهنمای گامبهگام بازیابی از جریمه پنگوئن

اگر مشکوک هستید که تحت تاثیر پنگوئن قرار گرفتهاید، این مراحل را دنبال کنید:

- آنالیز کامل پروفایل بکلینک: از ابزارهایی که در ادامه معرفی میشوند، یک خروجی کامل از تمام بکلینکهای سایت خود بگیرید.

- شناسایی لینکهای سمی: لینکها را بر اساس معیارهای بالا و با دقت بررسی کرده و لینکهای مشکوک را در یک لیست جداگانه (مثلاً در یک Google Sheet) قرار دهید.

- تلاش برای حذف لینکها: با مدیران سایتهای مبدا تماس بگیرید و از آنها بخواهید که لینک شما را حذف کنند. (این کار معمولاً موفقیتآمیز نیست، اما مستندسازی این تلاشها برای گوگل مهم است).

- ایجاد فایل Disavow: لیستی از دامنهها و URLهای سمی که موفق به حذف آنها نشدهاید را در یک فایل متنی با فرمت مشخص شده توسط گوگل، آماده کنید. احتیاط: Disavow کردن لینکهای اشتباه میتواند به سئوی شما آسیب بزند. این ابزار مانند یک چاقوی جراحی است و باید با دقت استفاده شود.

- ارسال فایل Disavow در سرچ کنسول گوگل: این فایل را از طریق ابزار Google Disavow Tool به گوگل ارسال کنید. با این کار به گوگل میگویید: “من این لینکها را تایید نمیکنم و نمیخواهم در ارزیابی سایت من لحاظ شوند.”

جعبه ابزار: معرفی ابزارهای تحلیل بکلینک

- Google Search Console: گزارش لینکها در سرچ کنسول یک نقطه شروع خوب و رایگان است، اما تمام لینکها را نشان نمیدهد.

- Ahrefs: به عنوان دارنده بزرگترین ایندکس بکلینک در میان ابزارهای تجاری شناخته میشود و برای تحلیل عمیق پروفایل لینک رقبا و خودتان بینظیر است.

- Semrush: ابزاری قدرتمند برای آنالیز بکلینک، شناسایی لینکهای سمی از طریق “Toxicity Score” و مدیریت کمپینهای لینکسازی.

- Moz Pro: ابزار Link Explorer این شرکت با معیار “Spam Score” به شما کمک میکند تا ریسک لینکهای خود را ارزیابی کنید.

انقلاب معنایی: مرغ مگسخوار، رنکبرین و BERT

از سال ۲۰۱۳ به بعد، گوگل وارد فاز جدیدی از تکامل خود شد: درک هدف و معنای پشت جستجو به جای تطبیق ساده کلمات کلیدی. این انقلاب با سه الگوریتم کلیدی رهبری شد که سئو را برای همیشه تغییر دادند.

الگوریتم مرغ مگسخوار (Hummingbird – 2013)

مرغ مگسخوار یک بازنویسی کامل بر کل موتور جستجوی گوگل بود. هدف آن، درک کوئریهای محاورهای و طولانی و ارتباط بین مفاهیم بود. مرغ مگسخوار با استفاده از گراف دانش (Knowledge Graph)، شروع به درک “موجودیتها” (Entities) و روابط بین آنها کرد. برای مثال، گوگل دیگر “برج میلاد” را فقط یک رشته از حروف نمیدید، بلکه آن را به عنوان یک “موجودیت” از نوع “برج مخابراتی” میشناخت که در “شهر تهران” (یک موجودیت دیگر) واقع شده است. این درک به گوگل اجازه داد تا به سوالاتی مانند “ارتفاع برج میلاد چقدر است؟” پاسخ مستقیم بدهد.

الگوریتم رنکبرین (RankBrain – 2015)

RankBrain یک سیستم هوش مصنوعی و یادگیری ماشین است که به عنوان سومین فاکتور مهم رتبهبندی معرفی شد. وظیفه اصلی آن، کمک به گوگل برای درک کوئریهایی است که قبلاً هرگز ندیده است (حدود ۱۵٪ از جستجوهای روزانه). RankBrain با تحلیل رفتار کاربران در نتایج جستجو، یاد میگیرد که کدام نتایج رضایت بیشتری را جلب میکنند. این الگوریتم به سیگنالهای تجربه کاربری (UX Signals) مانند نرخ کلیک (CTR)، زمان ماندگاری (Dwell Time) و نرخ بازگشت به نتایج (Pogo-sticking) وزن بسیار زیادی داد.

الگوریتم BERT (2019)

BERT (Bidirectional Encoder Representations from Transformers) یک جهش بزرگ در پردازش زبان طبیعی (NLP) بود. BERT به گوگل این توانایی را داد که روابط ظریف و دوطرفه بین کلمات در یک جمله، به خصوص حروف اضافه (مانند “به”، “از”، “برای”) را درک کند. این الگوریتم به گوگل کمک کرد تا معنای واقعی هر کلمه را در بستر آن جمله بفهمد و از سوءبرداشتهای رایج جلوگیری کند.

چگونه محتوای خود را برای این الگوریتمها بهینه کنیم؟

بهینهسازی برای این سه الگوریتم، به معنای نوشتن محتوای طبیعی، عمیق و کاربرمحور است:

- روی موضوعات (Topics) تمرکز کنید، نه کلمات کلیدی. به جای ساختن دهها صفحه برای عبارات مشابه، یک صفحه جامع و کامل (Pillar Page) بسازید که یک موضوع را از تمام زوایا پوشش دهد.

- از زبان طبیعی و محاورهای استفاده کنید. به سوالاتی که مردم واقعاً میپرسند (Who, What, Why, How) در محتوای خود پاسخ دهید.

- ساختار محتوای خود را با تگهای هدینگ (H2, H3) و لیستها بهینه کنید. این کار به گوگل کمک میکند تا ساختار و موضوعات فرعی محتوای شما را بهتر درک کند.

- از دادههای ساختاریافته (Schema Markup) استفاده کنید. با استفاده از اسکیما، شما به صراحت به گوگل میگویید که محتوای شما در مورد چیست (مثلاً یک دستور پخت، یک محصول یا یک رویداد) و به درک موجودیتها توسط گوگل کمک میکنید.

- برای Featured Snippets با ارائه پاسخهای کوتاه، مستقیم و دقیق به سوالات رایج، بهینهسازی کنید.

بهروزرسانیهای هسته (Core Updates): زلزلههای دنیای سئو

چند بار در سال، گوگل “بهروزرسانیهای گسترده هسته” یا Core Updates را منتشر میکند. این آپدیتها تغییرات مشخصی روی یک فاکتور خاص نیستند، بلکه بهبودهای کلی و گسترده در الگوریتم رتبهبندی گوگل هستند تا نتایج را به طور کلی مرتبطتر، مفیدتر و قابل اعتمادتری کنند. این آپدیتها اغلب بیشترین نوسان را در نتایج جستجو ایجاد میکنند.

E-E-A-T چیست و چرا در آپدیتهای هسته حیاتی است؟

اگر پس از یک آپدیت هسته دچار افت رتبه شدید، به احتمال ۹۹٪ مشکل شما به مفهوم E-E-A-T برمیگردد. این مخفف چهار کلمه کلیدی در دستورالعملهای ارزیابان کیفیت گوگل است:

- Experience (تجربه): آیا نویسنده محتوا، تجربه دست اول، واقعی و عملی در مورد موضوع دارد؟ آیا شما محصول را واقعا استفاده کردهاید یا فقط نقد دیگران را بازگو میکنید؟

- Expertise (تخصص): آیا نویسنده در آن حوزه یک متخصص شناخته شده و دارای صلاحیت است؟ مدارک، سوابق کاری و انتشارات مرتبط میتوانند این موضوع را اثبات کنند.

- Authoritativeness (اعتبار): آیا سایت و نویسنده به عنوان یک منبع معتبر و مرجع در آن صنعت شناخته میشوند؟ بکلینک از سایتهای معتبر، منشن شدن در رسانهها و نقدهای مثبت، اعتبار را میسازند.

- Trustworthiness (قابل اعتماد بودن): آیا کاربران میتوانند به اطلاعات و هویت سایت شما اعتماد کنند؟ شفافیت در مورد منابع، اطلاعات تماس واضح، گواهی SSL و سیاستهای حریم خصوصی شفاف، اعتماد را افزایش میدهند.

E-E-A-T به خصوص برای سایتهای YMYL (Your Money or Your Life) که با موضوعات حساس مالی، حقوقی و سلامتی سروکار دارند، اهمیتی حیاتی و غیرقابل چشمپوشی دارد.

آپدیت محتوای مفید (Helpful Content Update): اول انسان، بعد ربات

تاریخ معرفی: ۲۰۲۲

این آپدیت یکی از مهمترین تغییرات فلسفی گوگل در سالهای اخیر است و فلسفه “محتوا برای کاربر” را به یک قانون لازمالاجرا تبدیل کرده است. آپدیت محتوای مفید یک سیگنال منفی در سطح کل سایت (Site-wide Negative Signal) است که به طور مداوم محتواهایی را که به نظر میرسد صرفاً برای کسب رتبه در موتورهای جستجو ایجاد شدهاند (“محتوای سئومحور”)، شناسایی و جریمه میکند.

محتوای غیرمفید از دید گوگل چیست؟

- محتوای سئومحور: محتوایی که به جای پاسخ به نیاز کاربر، روی تکرار کلمات کلیدی، رسیدن به یک تعداد کلمه خاص یا پوشش دادن موضوعات پرجستجو بدون داشتن تخصص واقعی، تمرکز دارد.

- محتوای فاقد تخصص واقعی: نوشتن در مورد موضوعی که در آن تجربه یا دانش عمیقی ندارید (مثلاً نوشتن نقد یک محصول فنی بدون تست کردن آن).

- محتوای کلی و بدون ارزش افزوده: جمعآوری و بازنویسی اطلاعات از منابع مختلف بدون ارائه دیدگاه، تحلیل، داده جدید یا تجربه شخصی.

- محتوایی که به وعده خود عمل نمیکند: استفاده از عناوین جنجالی و فریبنده (Clickbait) که محتوای صفحه، پاسخگوی آن وعده نیست.

- پاسخ ندادن به سوال اصلی: محتوایی که در مقدمه وعده پاسخ به یک سوال را میدهد، اما در ادامه حاشیهروی کرده و در نهایت کاربر را بدون پاسخ رها میکند.

چکلیست تولید محتوای مفید

- آیا شما مخاطب مشخص و تعریفشدهای برای محتوای خود دارید و برای آنها مینویسید؟

- آیا محتوای شما به وضوح نشاندهنده تخصص و تجربه دست اول شماست؟

- آیا پس از خواندن محتوای شما، کاربر احساس میکند که پاسخ سوال خود را گرفته، چیز جدیدی یاد گرفته و زمانش تلف نشده است؟

- آیا محتوای شما یک تجربه رضایتبخش برای کاربر ایجاد میکند یا او را ناامید و سردرگم رها میکند؟

- آیا در تولید محتوا، دستورالعملهای گوگل در مورد E-E-A-T و آپدیتهای هسته را رعایت کردهاید؟

نکته کلیدی: تاثیر این الگوریتم تجمعی است. اگر بخش زیادی از سایت شما دارای محتوای غیرمفید باشد، حتی صفحات باکیفیت شما نیز ممکن است دچار افت رتبه شوند. بنابراین، حذف و بهبود محتوای بیکیفیت قدیمی به اندازه تولید محتوای جدید اهمیت دارد.

آینده سئو: هوش مصنوعی، SGE و فراتر از آن

دنیای جستجو در آستانه یک تحول بزرگ دیگر قرار دارد: جستجوی مبتنی بر هوش مصنوعی مولد. تجربه جستجوی مولد گوگل یا SGE (Search Generative Experience)، با ارائه پاسخهای مستقیم، خلاصهشده و چندوجهی در بالای نتایج، قصد دارد نیاز کاربر به کلیک روی لینکهای سنتی را در بسیاری از موارد کاهش دهد.

این تغییر برای سئو به چه معناست؟

- کاهش نرخ کلیک (CTR) و افزایش جستجوهای بدون کلیک: از آنجایی که کاربران پاسخ خود را مستقیماً دریافت میکنند، ترافیک ارگانیک برای کوئریهای اطلاعاتی (Informational Queries) به شدت کاهش خواهد یافت.

- افزایش اهمیت حیاتی E-E-A-T: هوش مصنوعی گوگل برای ساختن پاسخهای خود، به معتبرترین و قابل اعتمادترین منابع استناد خواهد کرد. بنابراین، تبدیل شدن به یک منبع مرجع، حیاتیتر از همیشه است.

- تغییر در تحقیق کلمات کلیدی: بهینهسازی برای سوالات بسیار خاص و طولانی (Long-tail queries)، مقایسهها، مطالعات موردی و موضوعاتی که نیاز به تحلیل عمیق، تجربه شخصی و دادههای منحصر به فرد دارند، اهمیت بیشتری پیدا میکند.

استراتژیهای انطباق با آینده سئو

- برندسازی را در اولویت قرار دهید: روی ساختن یک برند قوی و معتبر تمرکز کنید که کاربران مستقیماً آن را جستجو کنند و به آن اعتماد داشته باشند (Navigational Queries).

- محتوای منحصر به فرد و غیرقابل جایگزین تولید کنید: مطالعات موردی، گزارشهای تحقیقی بر اساس دادههای اختصاصی، مصاحبه با متخصصان، تجربیات شخصی عمیق و ویدیوهای آموزشی، محتواهایی هستند که هوش مصنوعی به سختی میتواند آنها را بازتولید کند.

- جامعه بسازید: از طریق شبکههای اجتماعی، خبرنامه ایمیلی و رویدادهای آنلاین، یک جامعه وفادار حول برند خود ایجاد کنید که ترافیک مستقیم و پایدار برای شما به همراه داشته باشد.

- فراتر از متن فکر کنید: روی بهینهسازی ویدیو برای یوتیوب، پادکست برای پلتفرمهای صوتی و تصاویر برای جستجوی بصری تمرکز کنید، زیرا این فرمتها در تجربیات جستجوی جدید نقش پررنگی خواهند داشت.

بخش پرسشهای متداول (FAQ)

۱. تفاوت جریمه دستی (Manual Action) و جریمه الگوریتمی چیست؟ جریمه دستی زمانی اتفاق میافتد که یک کارمند انسانی در گوگل سایت شما را بررسی کرده و به دلیل نقض شدید دستورالعملها، آن را جریمه میکند. این نوع جریمه در سرچ کنسول شما اطلاعرسانی میشود. جریمه الگوریتمی توسط الگوریتمها (مانند پاندا یا پنگوئن) به صورت خودکار اعمال میشود و هیچ اطلاعیهای دریافت نمیکنید؛ شما فقط متوجه افت شدید و ناگهانی ترافیک و رتبه میشوید.

۲. آیا ابزار Disavow هنوز هم کاربرد دارد؟ بله، اما با احتیاط فراوان. هرچند گوگل اعلام کرده که الگوریتم پنگوئن اکنون به صورت Real-time کار میکند و لینکهای اسپم را نادیده میگیرد، اما همچنان توصیه میشود که برای پاکسازی پروفایل لینک خود (به خصوص اگر سابقه لینکسازی کلاهسیاه دارید یا تحت حمله سئوی منفی قرار گرفتهاید) از این ابزار استفاده کنید.

۳. هر چند وقت یکبار باید محتوای خود را آپدیت کنم؟ پاسخ دقیقی وجود ندارد و به حوزه کاری شما بستگی دارد. برای موضوعاتی که به سرعت تغییر میکنند (مانند اخبار تکنولوژی یا قوانین مالیاتی)، آپدیتهای مکرر ضروری است. برای محتواهای همیشهسبز (Evergreen)، یک بازبینی و بهروزرسانی سالانه برای اطمینان از صحت و کامل بودن اطلاعات کافی است.

۴. با وجود آپدیت محتوای مفید، آیا سئوی تکنیکال دیگر مهم نیست؟ سئوی تکنیکال مهمتر از همیشه است. اگر گوگل نتواند به راحتی صفحات شما را پیدا کند، بخزد، رندر کند و ایندکس کند، حتی بهترین و مفیدترین محتوای جهان نیز دیده نخواهد شد. سئوی تکنیکال، زیربنا و فونداسیون یک استراتژی محتوای موفق است.

جمعبندی و گامهای بعدی: چکلیست نهایی پیادهسازی

درک الگوریتمهای گوگل یک ماراتن است، نه یک دوی سرعت. این الگوریتمها به طور مداوم در حال تکامل هستند، اما یک اصل همیشه ثابت است: گوگل میخواهد بهترین، مفیدترین و قابل اعتمادترین تجربه را برای کاربر خلق کند. اگر شما هم همین هدف را در تمام تصمیمات خود، از طراحی UI گرفته تا تولید محتوا، دنبال کنید، همیشه در مسیر درستی قرار خواهید داشت.

چکلیست نهایی شما برای موفقیت:

- محتوای باکیفیت، مفید و مبتنی بر E-E-A-T تولید کنید.

- یک پروفایل بکلینک طبیعی و معتبر از منابع مرتبط بسازید.

- هدف و رضایت کاربر را در مرکز تمام فعالیتهای خود قرار دهید.

- یک برند قوی بسازید که مردم به آن اعتماد داشته باشند و آن را جستجو کنند.

- تجربه کاربری بینظیری در سایت خود خلق کنید (سرعت، موبایل، ناوبری آسان و امنیت).

حالا نوبت شماست. با استفاده از این راهنما و چکلیستها، وبسایت خود را با دیدی منتقدانه بازبینی کنید. از یک بخش کوچک شروع کنید، مثلا ۱۰ صفحه از مهمترین مقالات یا محصولاتتان. آیا آنها واقعا بهترین گزینه در وب برای مخاطب شما هستند؟ این مسیر شاید چالشبرانگیز باشد، اما نتایج آن برای کسبوکار شما پایدار، قابل دفاع و بسیار ارزشمند خواهد بود.

برای دریافت آموزشهای پیشرفتهتر و مشاورههای تخصصی سئو، میتوانید به وبسایت من در mortezaazimi.ir مراجعه کنید. موفق باشید!